Aunque no lo había comentado todavía por aquí, me he comprado una impresora 3D. Ha sido un proceso largo y laborioso, tanto en el montaje (que es como un mueble del IKEA, pero a lo bestia) como en la puesta en marcha y calibración del aparato, que al ser baratera-chinorris no es moco de pavo, ya que hay que pelearse con instrucciones contradictorias, piezas de ínfima calidad que hay que sustituir y todo tipo de peripecias.

Pero ahora que más o menos he visto la luz al final del túnel y ya tengo una impresora bastante operativa, creo que no está mal resumir un poco el ABC de la calibración, porque guías para calibrar cada uno de los diferentes aspectos hay a patadas, pero lo que no he encontrado yo es una guía que te diga cuáles son los aspectos más importantes para calibrar, en qué orden hay que hacerlos y cómo llevarlos a cabo. Aquí va lo que haría yo, desde mi humilde experiencia:

1. Ajustar extrusión

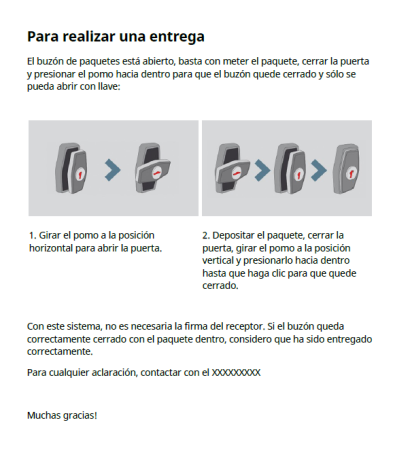

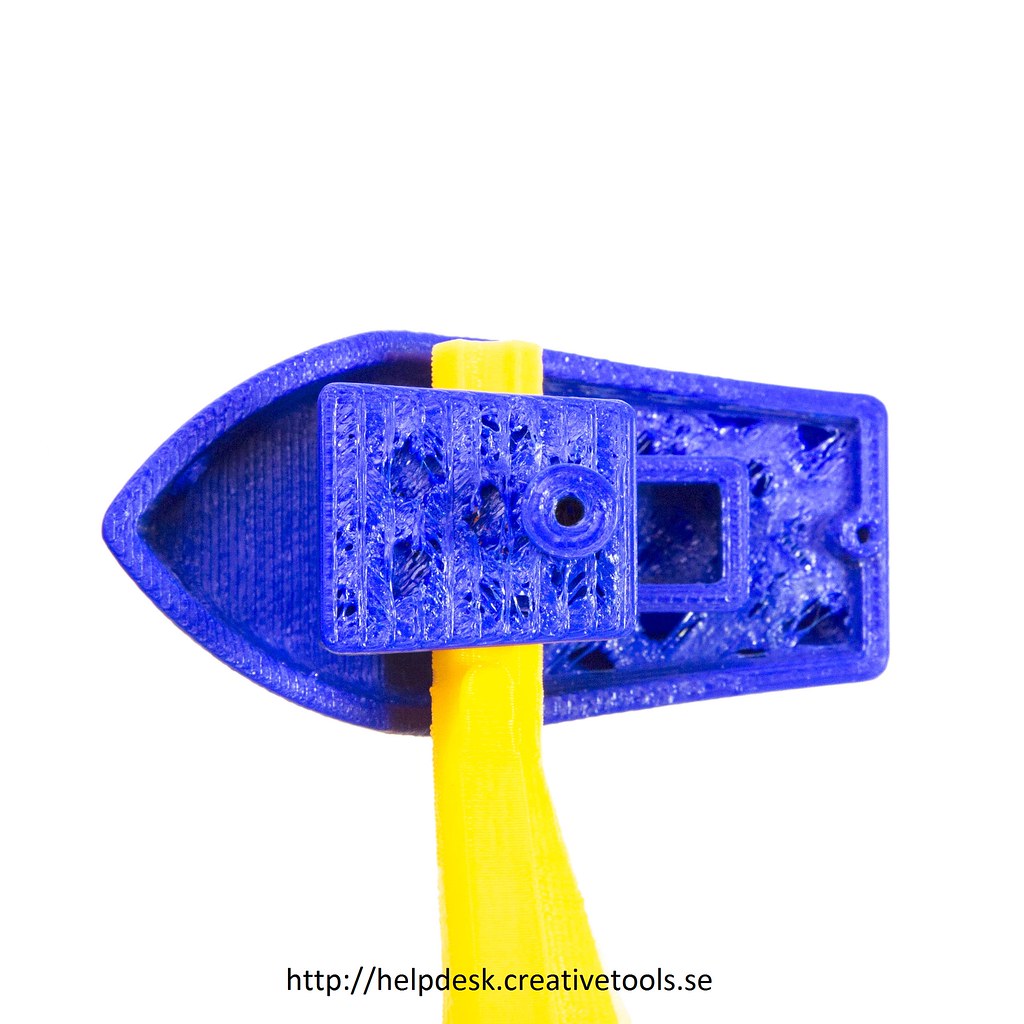

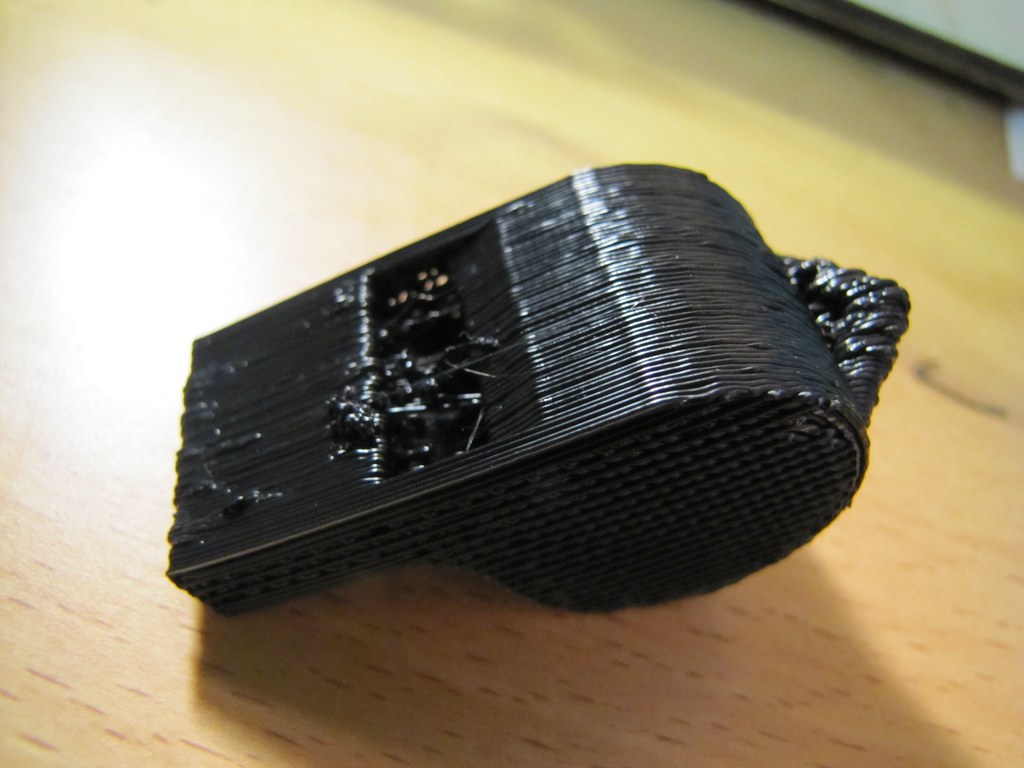

Un factor crucial es asegurarnos de que el extrusor está «empujando» la cantidad correcta de filamento al imprimir, ya que si está metiendo filamento de más quedarán chorreones y pegotes por todas partes, y si está metiendo de menos quedarán las paredes birriosillas y como con huecos. Creo que lo suyo es hacer esto lo primero porque, a diferencia de los demás ajustes que están todos más o menos interrelacionados, la extrusión es totalmente independiente del resto, por lo que si lo ajustamos bien de inicio nos ahorraremos repeticiones de calibraciones posteriores.

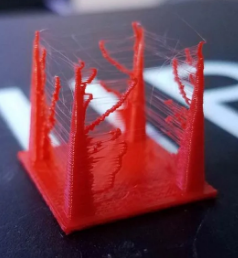

Underextrusion (¿infraextrusión? no lo sé decir en spanish). Se ve cómo las paredes supuestamente sólidas tienen huecos. |

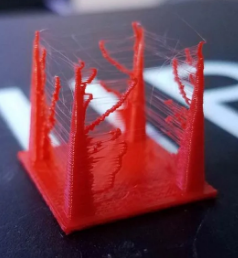

Y overextrusion. Ojo a los churretones y al exceso general de filamento |

De lo que se trata es de ver si el valor (en número de pasos/mm) que tiene la impresora en su EEPROM para el motor que empuja el filamento es correcto, o hay que aumentarlo/disminuirlo. Para verlo hay que decirle a la impresora, usando el control manual, que pase por el extrusor una cantidad fija de filamento, y luego medir cuánta ha pasado en realidad. Si nuestro extrusor permite pasar filamento sin quemarlo, es tan sencillo como hacer dos marcas con el boli (una antes y una después) y medir. Si el filamento hay que quemarlo sí o sí, entonces podemos marcar en el filamento un punto lejano al extrusor (p. e. a 30 cm), medir la distancia extrusor-punto, extrusionar 10 cm, y volver a medir la distancia extrusor-punto. Idealmente deberían ser 20 cm exactos, si son más o menos hay que ajustar el valor según una regla de tres.

Por ejemplo, si medimos un punto a 30 cm del extrusor, le decimos que queme 10 cm de filamento, y luego al medir resulta que marca 19,5 cm, es que está extrusionando de más (ha empujado 10,5 en vez de 10). Si en las opciones ponía que el parámetro «E steps/mm» es de 2400, habrá que hacer la regla de tres y reducirlo a 2285,71 (2400*10/10,5). Repetir el proceso hasta que lo clavemos.

Si bien el método de medir el filamento debería ajustar bien la cuestión, al final lo que importa es el resultado, por lo que la prueba final es imprimir algo como esto. Es un modelo muy sencillo y rápido que nos permite ir ajustando el valor de extrusión, hasta que los dos cilindros encajen bien. Cuando uno entre en el otro sin salirse o hacer fuerza, es que tenemos la cosa bien configurada.

También conviene repetir el proceso cuando cambiemos de marca de filamento, porque no todos se comportan igual. Incluso entre rollos de la misma marca puede haber diferencias, por lo que no está de mal dedicarle 5 minutos.

2. Nivelado de la cama

Como para las siguientes calibraciones hay que empezar a imprimir algo, es crucial tener bien nivelada la cama caliente. Esto consiste en ajustarlo todo para que la punta del extrusor esté, en su posición más baja, casi rozando la superficie de la cama, y lo típico es ajustar la altura de manera que podamos pasar un folio por debajo, y notemos cómo roza un pelín.

Dependiendo del modelo se ajustará con los tornillos de la cama, o directamente desde los menús de la impresora ajustando la altura del extrusor con la rueda. Hay que tener en cuenta, eso sí, que cada vez que ajustemos un punto igual estamos desgraciando el que habíamos nivelado antes, por lo que hay que tener paciencia y repetir y repetir hasta que las cuatro esquinas queden bien. Generalmente este ajuste puede durar mucho tiempo si no hacemos barbaridades (como estirar algo recién imprimido para despegarlo, sin esperar a que se enfríe), y si no la tenemos siempre podemos hacerle un tuning a la impresora y ponerle un sensor de autonivelado, que mola un montón.

Hay modelos en Thingiverse que pueden ayudar a ver si tenemos la cama bien nivelada, pero vamos, al final la prueba del folio es lo más directo y sencillo, y en el fondo los modelos nos pueden liar más, porque a lo mejor el problema es de temperatura o de extrusión, y no salen bien aunque esté todo bien nivelado.

3. pasos/mm de los ejes

Ahora que ya estamos en disposición de empezar a imprimir algo, hay que asegurarse de que, cuando la impresora diga que hay que moverse 10 mm en una dirección, se mueva 10 mm y no 9 ni 11. Es básicamente lo mismo que hemos hecho con el extrusor pero para los ejes, y para hacerlo basta imprimir el típico cubilete de 20 mm, medir con un calibre el resultado, y ajustar según la regla de tres los valores que tenga guardados la impresora (generalmente está en la EEPROM, son los marcados como X, Y o Z steps/mm).

Por ejemplo, si el cubilete es de 20 mm y nos sale uno de 18 mm, hay que ir a la configuración y ver cuántos pasos/mm tiene configurados para el eje X. Si son, por ejemplo, 576, aplicando una regla de tres sabemos que hay que subir el valor a 640. Lo mismo para el eje Y, y el eje Z. Cada vez que cambiamos un valor hay que volver a imprimir el cubilete, y repetir hasta que clavemos la medida.

Aunque lo típico es usar un cubo, a mí personalmente me gusta más algo como esto o esto. Usa menos filamento, y al ser de mayor tamaño el ajuste es más preciso. También tiene varios puntos donde medir, por lo que podemos ver si el desajuste es por culpa de los pasos/mm, o simplemente es un tema de dilatación del plástico (si falla igual en todas las distancias puede ser un tema de dilatación, si falla más cuanto más largo sea el objeto serán los pasos/mm).

Como antes, conviene repetir el proceso hasta que las dimensiones sean exactas.

4. Encontrar la temperatura ideal

Aunque en principio el propio fabricante del filamento ya nos dice cuál es la temperatura adecuada, tenemos que fiarnos de eso menos que de las solteras libres en tu zona que te juran amor eterno en los banners de Pirate bay. Cada impresora es un mundo, cada sensor de temperatura también, y al final las cosas hay que probarlas.

Un método apañado es usar una torre tipo esta, pero ojo, que no vale con imprimirla tal cual, ya que entonces se imprimiría toda ella a la temperatura que tengamos configurada. Lo suyo es cargar el fichero STL en nuestro slicer de confianza, generar el G-Code, y luego editarlo con cualquier editor de textos. Un fichero G-Code no es más que un fichero de texto con comandos de impresión, y lo que tenemos que hacer es intercalar comandos de cambio de temperatura cada centímetro, de manera que la temperatura de impresión coincida con el numerito del objeto a cada altura. Para eso, lo suyo es buscar el texto Z10, y la primera ocurrencia será el primer comando que se ejecuta a 10 mm de altura. Justo antes de ese comando metemos un comando de cambio de temperatura (M109 S225 para la torre de ejemplo que he enlazado a partir de los 10mm de altura), y lo mismo para Z20, Z30, etc. Luego imprimimos ese G-Code empezando por 230 ºC, y veremos cómo, cada 10 mm, baja 5 grados. Una vez hecho esto ya podemos guardar el G-Code para la próxima vez que cambiemos el filamento, así ya está preparado.

Una vez impresa la torre, es tan sencillo como evaluar a qué temperatura ha quedado mejor, y configurar nuestra impresora para que, con ese filamento, se ponga siempre a esa temperatura. Y aunque sea un coñazo, una vez tenemos la temperatura ideal conviene ver si la calibración de los ejes X, Y y Z sigue estando bien, porque igual ha cambiado.

5. Retracción, velocidad y otras frivolités

En este punto ya tenemos todo bastante bien ajustado y las cosas nos deberían ir quedando relativamente bien. Ya sólo nos falta tocar detallitos:

Retracción

Cuando la impresora tiene que imprimir cosas que están alejadas unas de otras, «estira» un poco el filamento hacia atrás, básicamente para que no caigan chorretones mientras se mueve de un sitio a otro. Si no hay retracción, o es insuficiente, el efecto es que quedan hilillos («stringing») entre las partes de un modelo. Aquí hay dos factores: la distancia de retracción y la velocidad de retracción, que hay que ir tocando hasta que encontremos los valores ideales, ayudándonos de modelos como este o este.

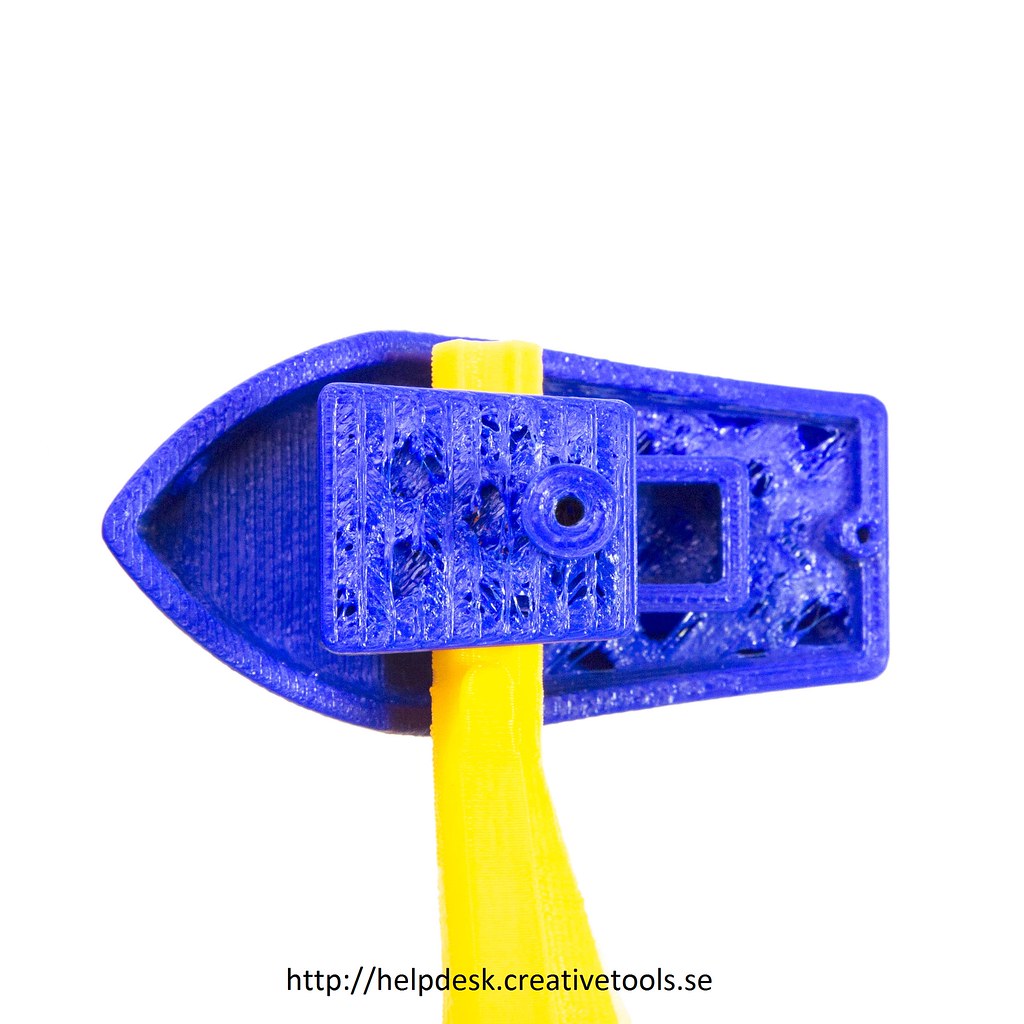

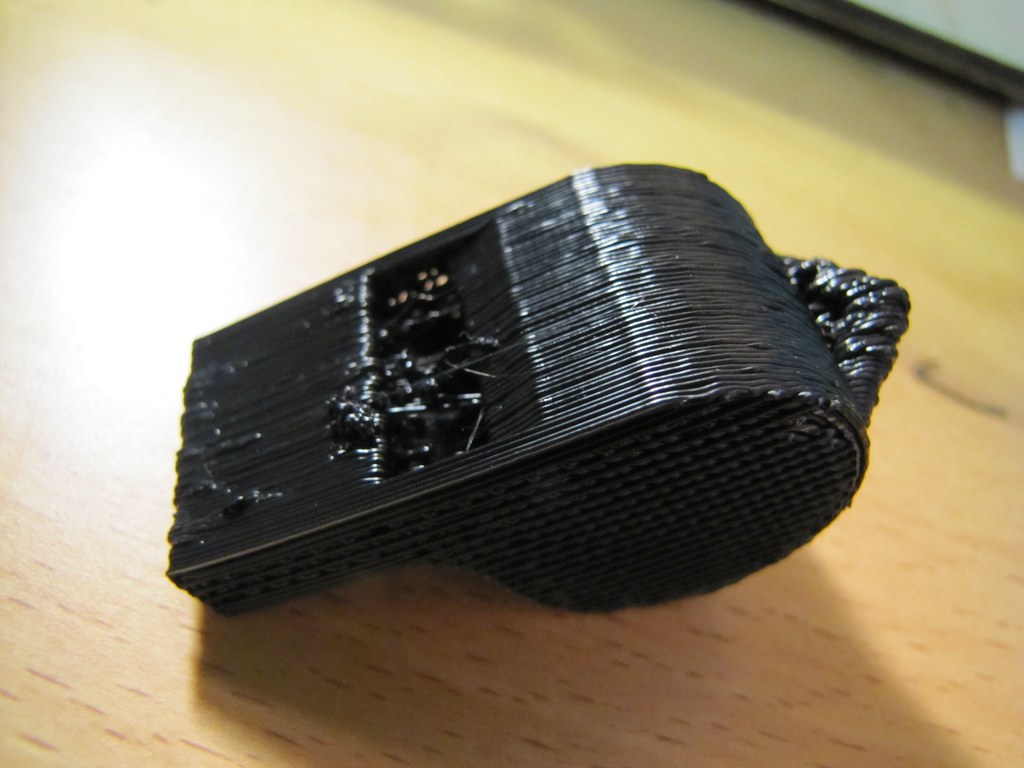

Hilillos entre partes del objeto por culpa de una retracción mal configurada

Ojo, que un exceso de retracción tampoco es bueno, y nos puede provocar atascos si, por ejemplo, nuestra ventilación no es excelente, un filamento caliente sube hacia arriba por una retracción, y al volver a bajar, medio fundido, se retuerce y nos atasca el extrusor.

Velocidad

Lo mejor al principio es ir despacito, es la mejor manera que todo salga bien. Pero si, cuando tengamos todo afinado al dedillo, queremos saber hasta dónde podemos darle caña a nuestra impresora sin producir desastres, podemos usar unos cubos como estos, (obviamente ajustando la velocidad para cada uno de ellos a la que tiene sobreimpresa), y luego comparar.

Pero que los cubos salgan bien tampoco quiere decir que un modelo con muchos detalles pequeños no vaya a necesitar menos velocidad, por lo que al final es cuestión de experiencia y valorar hasta qué punto nos la queremos jugar: no es lo mismo imprimir demasiado rápido un esbozo de 15 minutos y que salga mal, que que se nos vaya a la porra una impresión de 4 horas porque a las 2h y media había un detalle que necesitaba frenar un poco.

Otro ajuste interesante es que (al menos en Cura) se puede definir un tiempo mínimo por capa. Si ponemos este tiempo bastante alto, el efecto será que a grandes rasgos irá todo igual, pero que cuando lleguemos a los detalles pequeños (que suelen ser capas muy cortas) bajará la velocidad para respetar ese tiempo mínimo. Por defecto suele venir a 2-5 segundos, yo lo subo a 10-15. Para el 90% del modelo no hay cambio alguno, y en los pequeños detalles se agradece la bajada de velocidad.

Modificaciones del hardware

Como la mayoría de impresoras 3D son hardware abierto, hay mil manera de mejorarlas cambiando piezas o imprimiendo partes adicionales. Ejemplos de cosas que se pueden hacer:

- Añadir un ventilador en la punta del extrusor. Cuando se imprime con PLA, ayuda a que el plástico se solidifique inmediatamente, por lo que se evitan deformaciones del material y las estructuras complejas quedan mejor.

- Cambiar los rodillos roscados verticales (que suelen venir en impresoras 3D baratas y muchas veces están medio doblados o tienen imperfecciones) por rodillos de acero (lead screws). Mejora la estabilidad en el eje Z, y evita irregularidades.

- Convertir la impresora de extrusión directa a Bowden. Eso quiere decir separar el extrusor del hotend, de manera que en el carril del eje X sólo se pondría el hotend. El extrusor estaría aparte (normalmente en la parte superior de la impresora), y «empujaría» el filamento en vez de estirarlo. La ventaja es que quitamos un montón de peso del eje X, con lo que se puede aumentar la velocidad notablemente.

- Nivelación automática de la cama añadiendo un sensor que mida la altura, con lo que tenemos nivelado 100% perfecto cada vez.

En fin, que el límite lo ponemos nosotros.